4.2 信息对数量度原理

令x和y是两个离散随机变量,它们的可能结果分别是xi(i=1,2…n)和yi(i=1,2…m)。假设我们观察其中的某个结果Y=yi,并希望定量的求出由于Y=yj的出现所提供的关于X=xi(i=1,2…n)的信息量。当X和Y统计独立时,Y=yj的出现对事件X=xi的发生不提供什么信息。当X和Y相关(不是统计独立)时,即Y=yj的出现决定于X=xi的发生,那么信息量就由事件X=xi来确定[4]。满足这些条件的一个合适的度量是条件概率:

Pr(X=xi|Y=yj)=p(xi|yj) 公式(16)

除以概率Pr(X=xi)=p(xi)的对数,由于事件Y=yj的出现所提供的关于事件X=xi的信息量可定义为:

![]()

公式(17)

其中,IM(xi,yj)称为xi和yj之间的互信息(mutual infor mation)。

当X和Y为统计独立时,p(xi|yj)=p(xi),因此,IM(xi,yj)=0。另一方面,当事件Y=yi的出现唯一决定了事件X=xi的发生时,则

![]()

此时,IM(xi,yj)为X=xi的自信息。

IM(xi,yj)反映了事件X和Y的可能结果,也可用联合事件出现的概率p(xi,yj)或频次对IM(xi,yj)进行简单加权,则

![]()

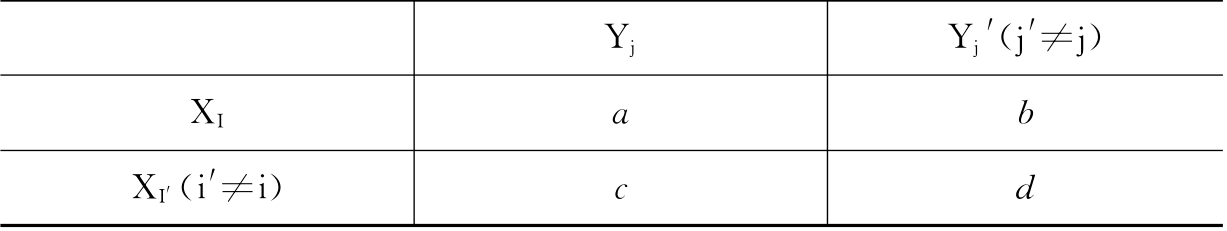

为方便应用,可以构造两个事件的出现频次表(见表4-7)。假设:

X代表事件A,Y代表事件B;

a代表xi和yj共同出现的频次;

b代表xi出现而yj不出现(即yj′)的出现频次;

c代表xi不出现(即)而yj出现的出现频次;

d代表xi不出现(即XI′)和yj不出现(即yj′)的出现频次;

a+b=Yj在样本中的出现频次,c+d=Xi在样本中出现的频次。

表4-7 两个事件的出现频次表

则IM(xi,yj)定义为:

![]()

IM(xi,yj)可理解为xi和yj之间的关联程度。IM(xi,yj)值越大,二者的关联程度就越大,其值反映了xi和yj两个联合事件的出现可能性大小。

假设在YBK1中,总样本量为181023,设X代表事件分类号,Y代表事件标引词,标引词“金融”的出现频次为80,分类号“F83”的出现频次为300,分类号“F83”和标引词“金融”同时出现的频次为30,则标引词“金融”和分类号“F83”的互信息量(IM)为5.42。

![]()

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。