组织研究中的元分析方法:改善其效度的视角

冯 明 任华勇[1]

一、引 言

元分析(meta-analysis)是以综合已有的研究成果为目的,对来自于单独研究中的大量结果进行统计学分析的方法。[2]元分析是对已有研究结果的总体分析,也有人称为“总分析”。元分析运用了测量和统计分析技术,对分别进行了的一些实验或研究进行定量化的总结,找出一组相同课题研究的结果所反映的共同效应。[3]元分析的焦点集中在变量与构思之间关系(包括调节关系)的精确与准确的校准上。一旦这些关系被校准了,焦点可以转移到理论构建以及理论检验上。[4]该方法实际上是一种对有关某一特定课题的现存研究成果进行评价分析的方法,但是它又不同于传统的对研究成果的评价方法,这主要是因为元分析方法引入了数量化的且具有统计基础的评价指标,从而使对各种研究成果的客观比较成为可能。[5]

自从元分析问世以来,其已经渗透到社会科学的各个领域中,促进了各学科的发展,在组织研究中,该方法几乎遍布所有学科。[6]特别是随着近年来的普及,有许多学者对其进行专门的研究,不断出现的研究成果也提升了元分析方法的效度。[7]本文在综合元分析技术相关领域中的众多研究成果的基础上,着重探讨了对提升元分析方法效度具有重要意义的四个研究主题。

二、对元分析中重复研究成果的处理

(一)重复研究成果相关的概述

由通过相同数据集所得出的研究成果以及在不止一种刊物中被重复发表的研究成果很可能会使元分析的结论发生偏倚。之前各领域所进行的元分析中,很多都纳入了重复的研究成果,这严重影响了组织研究中元分析方法的效度。[8]事实上,对各种研究结果进行综合而不保证这些结果的样本独立性已经违反了元分析的一个基本假设,而且这很可能会导致错误的结论。[9]

(二)对重复研究成果的鉴别与处理

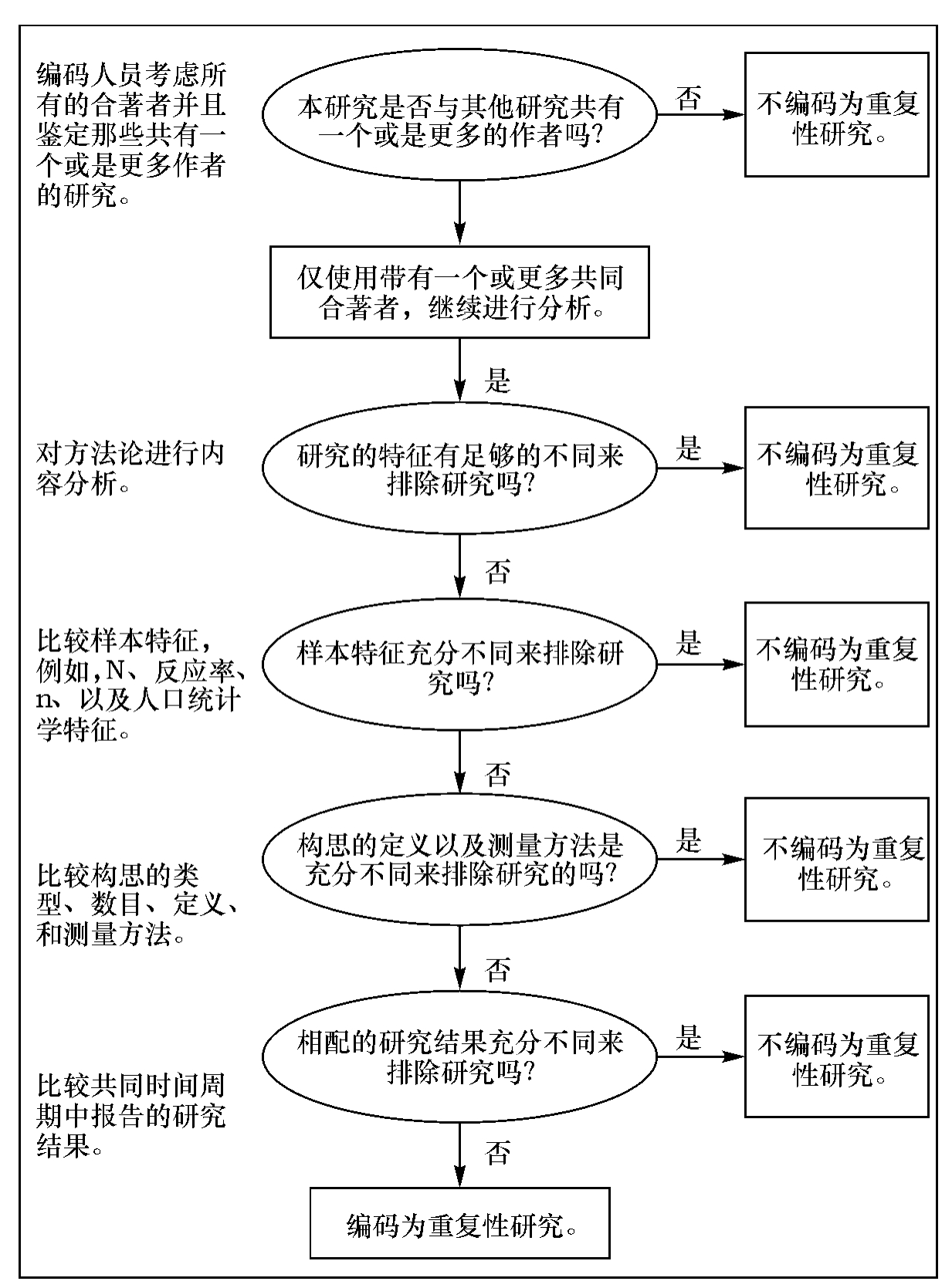

最近,美国西弗吉尼亚大学的学者Wood(2008)开发出了一种试探法来检测重复研究[10],而在这之前一直都没有系统化的方法来检测外显的或是潜在的重复研究。图1即是该试探法的逻辑步骤。

图1中所提到的“研究的特征”包括:所有的合著者、样本框架、样本特征、构思(包括定义、描述和测量方法)、以及研究结果。“样本特征”包括:回答者或是参与者的数目、反应率、以及该数据的人口统计学特征。[11]

对重复研究的鉴定首先需要搜索初始研究文献。该试探法一共有五个主要步骤(图1中椭圆里面的内容),其中第四步是检查各个研究中构思的定义以及测量方法是否是充分不同,这为判断研究是否具有独立性提供了很好的指导。Wood(2008)认为:“即使是在最隐蔽的重复性研究中,这一层面的细节也不太可能被遮住……研究人员还需要比较各个实验中的自变量、因变量、处理方式、所使用的量表、测验量表的措辞以及实证效度数据。从第一步到第四步都是在寻找用来证实研究具有独立性的证据”。[12]

图1 检测试探法

(资料来源:Wood,J.A.(2008).Methodology for dealingwith duplicate study effects in ameta-analysis.Organizational Research Methods,11,79-95.)

如果这个试探法被应用并且结果正是对重复研究的检测,那么该如何来处理那些重复性研究呢?Wood详述了许多可供选择的处理措施,并且在最后建议可以把重复研究综合到一个单一效应值估计,并且作为一个单一的研究使其成为元分析的一部分,这个方法收集了重复研究中所包含的信息,同时保留了在进行元分析时统计上的独立性。[13]在这一点上,Hunter和Schmidt(2004)也作过类似的建议。[14]

针对Wood所提出的这个用来筛选重复研究的试探法,Bobko与Roth(2008)指出,重复研究的问题也许要比共同的作者来得更加广泛;此外,研究人员也许会使用业内知名的国内或是国际性数据库,并且这可能导致非独立的数据或样本,即使是在不同的刊物上有完全不同的作者。[15]特别是,不同的作者已经发表了来自重叠年份的大型数据库。例如,Waldman和Avolio(1991)应用了GATB从1970年到1984年的数据[16],而Rotundo和Sackett(1999)应用了GATB从1972年到1987年的数据。[17]针对非独立性的问题,Wood提醒要谨慎地筛选元分析的来源文献是一个非常及时并且有用的建议,这应当引起元分析研究人员的注意。[18]

虽然已经开发出了这样一个非常好的试探法,但是对于如何预防重复性研究出现的问题,现在仍然没有妥善的解决方法。这不仅在组织领域中存在,在其他所有的科研领域中也都存在,困扰着广大的研究人员。Wood(2008)提出了两点建议:一是按照某个科学标准(如,国际医学杂志编辑委员会),要求研究人员签署一个唯一发表的书面协议;二是元分析的研究人员都应当检查他们所列入的研究结果,确保不具有重复性,如果不能确定,需要联系初始研究的作者进行核实。[19]我们初步构思可以从两个方面入手:思想上严格要求以及制度上严格把关。Wood所提出的两个建议可以认为是属于制度范畴。从个人与机制这两方面来着手,主观客观形成一种合力,使得重复性研究无从产生。鉴于目前科学研究的现状,要预防重复性研究出现的问题,未来还有很长的一段路要走。

尽管如此,Wood对此所作的探索都具有相当重要的意义。Schmidt(2008)这样评价道:“这篇文章首次提出了一个系统化的步骤来检测重复研究。虽然这个试探法并没有消除主观判断的需要,但是它确实把决策过程进行了系统化,使其更加客观以及可能更加精确,它也许会增加不同研究人员所进行的各个元分析之间的一致性”。[20]Wood建议研究人员参照图1中所示的步骤来对检索出来的文献进行检验,确保在把重复性研究筛选出来的同时而不会误判(其中误判包括:没有识别出重复研究而被直接纳入到元分析中,或是把本不是重复的研究判断为重复的,进而按重复研究来进行处理,这两种误判都可能会使元分析的结果发生偏倚);此外,他所提出的如何来对重复性研究进行处理的观点,既收集了重复研究中所包含的信息,同时又保留了在进行元分析时统计上的独立性。[21]这些都在一定程度上改善了元分析方法的效度与评分者信度,其在元分析方法乃至组织研究相关方法论的发展过程中都具有里程碑式的意义。

三、元分析中模型的选择

固定效应模型以及随机效应模型代表了分析和理解元分析中数据的两种不同方法。应用固定效应模型或是随机效应模型来进行统计分析,进而得到效应合并值的点估计和方差估计。[22]Kisamore和Brannick(2008)通过研究阐明了元分析模型的选择(主要是固定效应模型与随机效应模型)对所得出的研究结论具有重要的影响,使用不同的元分析模型,会影响到平均效应值以及随机效应方差分量(REVC)的估计。[23]所谓的随机效应方差分量,即是一个对无限样本效应值方差的估计。[24]在固定效应分析中,假定REVC为0。[25]

(一)草一木固定效应模型与随机效应模型

固定效应模型假设每个研究的效应值估计一个共同的总量值(参数)。本质上,这相当于假设了,除了取样误差以外,不同研究中的效应值是恒定的。固定效应分析允许研究人员估计总量效应值并且给定一个围绕参数的置信区间来进行显著性检验。相较之下,随机效应模型假设总量效应值是变化的而不是恒定的。也就是说,如果每个局部研究使用一个无限样本,局部效应值将不会相等;而是,效应值会有一个分布。随机效应方法允许研究人员估计无限样本效应值分布的均值以及给定围绕那个均值的一个置信区间。一般来讲,随机效应情形下这样的一个置信区间通常要比固定效应情形下的来得更大。[26]换句话说,如果调节变量不起作用,这两个方法则会产生类似的结果。然而,如果调节变量起作用(即随机效应方差分量REVC不为0),那么由随机效应分析所得到的置信区间会更大。[27]

Kisamore和Brannick(2008)研究的模型包括:Hedges和Vevea固定效应模型[HVFE],Hedges和Vevea随机效应模型[HVRE],以及Hunter和Schmidt随机效应模型[HSRE],前面的这一种固定效应模型与两种随机效应模型都具有代表性,同时在以往的研究中也是经常用到的;此外还有修正的随机效应模型,如修正的Hedges和Vevea随机效应模型[HVREC],以及修正的Hunter和Schmidt随机效应模型[HSREC]。修正的Hunter和Schmidt模型使用样本容量为权重,而修正的Hedges和Vevea随机效应方法则使用方差的倒数为权重。[28]

(二)固定效应模型与随机效应模型使用的结论

Kisamore和Brannick(2008)对来自两个元分析研究中的实际数据进行了再分析,通过使用多个模型(包括固定效应模型与随机效应模型),发现在进行一个元分析的过程中(例如,选择不同的模型、加权策略以及修正措施),选择不同的方法会影响结果,其中最显著的是影响了REVC;此外,哪怕都是应用随机效应方法,选择不同的模型(例如,HVRE,HSRE,HVREC,HSREC)对平均效应值的估计也不尽相同。[29]

Kisamore和Brannick的研究是首次通过固定效应方法与随机效应方法来独立地对已经发表了的元分析中的数据进行分析,然后对各自的结果作了比较。[30]他们发现,过去的元分析大部分都是基于固定效应模型并且建议元分析研究人员对数据进行随机效应分析或是混合效应分析,以及报告估计的REVC。如果REVC是小的,哪怕来源文献的数目较少,固定效应分析与随机效应分析都将会产生本质上相等的结果;如果REVC是大的,通过使用随机效应分析,研究人员对平均效应值大小(即,均值置信区间的大小)的不确定性会有一个更好的理解,换句话说,如果REVC是小的,这两者之间几乎没有差异,但当REVC是大的,随机效应估计会更好一些。[31]事实上,过去已有研究人员建议在理论与实践中使用随机效应模型,同时随机效应模型所作的假设一般要比固定效应模型所作的假设更站得住脚。[32]

总的看来,Kisamore和Brannick(2008)的研究表明即使采用相同的数据集,使用不同的元分析方法也能够导致充分不同的结果与结论;即使当两种不同的分析方法所产生的均值是类似的,由于在估计效应值的可变性上的差异,也会造成对数据的不同理解。此外,他们的工作对元分析方法效度的不断改善具有重要的意义:第一,他们把元分析模型的选择也看作是一个决策的步骤,该步骤能够影响从元分析中所得出的结论,扩展了Wanous等人(1989)所提出的元分析框架;第二,他们着重强调了REVC在理论上的重要性;第三,对于组织研究领域,他们在实际数据中发现了大的REVC。基于此,他们建议研究人员考虑使用随机效应模型。[33]

四、用来评估分类变量调节效应的各种元分析方法的比较

分类变量的范围很广泛,包括性别(男和女)、种族(多数和少数)、职别(初级、中级、高级)等,管理以及相关领域中的许多理论都存在着分类变量调节效应的作用。[34]现在,许多研究人员都是应用元分析方法来评估分类变量的调节效应。

研究人员选择一种研究方法,很多时候是基于习惯、某种软件包的使用舒适性以及各人的使用偏好等,而不是基于各种方法的优缺点。[35]事实上,这种情形在组织领域的研究中是很普遍的,其带有较强的主观性。元分析也不例外,出现这种情况的一个原因是缺乏与元分析方法有关的使用指南。[36]一份有技术含量的使用指南对于完善元分析方法的理论体系、规范元分析方法的应用流程都起着不可忽略的作用;同时,有了使用指南,还可以系统、具体地指导研究人员正确应用该方法。

现有的元分析方法有许多种,在特定的理论发展与研究设计条件下,哪种元分析的方法才是最有效的呢?在Aguinis,Sturman和Pierce(2008)之前并没有学者对此作专门的研究。同时对于评估哪种元分析方法应当用来检验与调节变量有关的假设,先前的研究都没有对此进行充分地描述。Aguinis,Sturman和Pierce选用了具有代表性的三种元分析方法,它们分别是(a)Hedges和Olkin(1985)元分析方法[37],(b) Hunter和Schmidt(1990,2004)元分析方法[38],以及(c)精炼的Aguinis和Pierce(1998)元分析方法。[39]他们根据I类错误率、II类错误率以及各种方法估计总量效应值的能力,评估了这些方法的效度。

为了在评估分类变量调节效应时选择合适的元分析方法,达到提升元分析方法效度的目的,Aguinis,Sturman和Pierce经过研究得出的结论为:第一,Hunter和Schmidt方法对调节效应大小产生了最精确的估计,因此它应被用于点估计。第二,关于同质性检验,当理论发展处于初始阶段并且没有有力的基于理论的假设要被检验(即探索性检验或是后验检验),这些情形下最好是应用Hunter和Schmidt方法;当理论发展到达高级阶段时(即验证性检验和先验检验),Aguinis和Pierce方法是最好的。第三,对于调节效应检验,所有这三种方法产生了类似的I类错误率和II类错误率,因此使用任何一种方法都可以。第四,Hunter和Schmidt方法是最少受到渐渐增多的范围约束以及测量误差影响的,并且Aguinis和Pierce同质性检验II类错误率是最少受到这些研究设计条件影响的。因此,选择其中一种方法需要考虑范围约束以及测量误差是研究设计问题(该问题出现在要被分析的元分析纳入文献中)的程度。最后,对于同质性和调节效应测验,所有这三种方法都是同样易受I类错误与II类错误率影响,随着范围约束变得更加严格以及测量误差的增加,此时Aguinis和Pierce方法也许具有微弱的优势(大约0.01)。[40]

五、对系统化偏倚的处理

(一)系统化偏倚的介绍

在进行元分析的过程中有一些问题经常会被研究人员所忽视,如在统计中,研究人员经常会采用对各个数值进行加总、计算平均值的方法,从而让相关的误差达到平衡,如果误差是随机的,则此方法有效;但如果误差是系统的,则平均后,偏倚还是存在,并没有得到消除。换句话说,如果模型是“X=真实+偏倚+误差”,则X的平均值将导致“真实+偏倚”而不仅仅是“真实”。[41]只是这样处理的话,元分析后所得到的结果仍旧会保留这样的一个偏倚。这样也就不能得出符合实际的结果,由此所得出的结论也不够准确,从而不能正确地指导实践。

(二)对系统化偏倚问题的解决措施

(1)对来源文献把好关,确保所纳入文献的质量。事实上,早在1998年,K raemer,Gardner,Brooks和Yesavage(1998)就提出了:“根据合适的理论和对研究问题的陈述,一个研究如果不能达到同行专家所提出的标准,则不应当把该研究纳入到元分析中”。[42]根据这个限定,对于特定领域中的某个研究问题,即使研究人员所知道的相关理论并不足够充分或是并不存在足够的合适初始研究,Kraemer等人的这个结论也并非一定就是错误的,并且可能比着手收集那些可得到的数据(但其却与研究问题不相符)来得更有用。[43]这也就对“设定研究纳入/排除标准”中的“标准”有所要求,研究人员需要仔细确定标准,以使得后续的元分析能够得出客观、准确的结论。

(2)使元分析方法与法则关系方法(nomological network)有机结合,实现优势互补。在先前几年的研究中,Bobko以及他的同事(Bobko&Roth,2003;Bobko&Stone-Romero,1998)已经提倡多组研究人员来进行更广泛的、但可能是较少的、初始的研究,这种设计能够同时研究一个带有较大样本容量的、更宽的、与变量相关的法则关系,并且对模型错误阐述不太敏感。[44]简单介绍一下法则关系。科学地讲,要“弄清楚某事是什么”即意味着要阐明其发生所依循的法则,所提到法则的连锁系统,其构成了一个理论为法则关系;法则有效性是指构思能被采纳的必要条件是它存在于一个法则关系中,法则关系中的某些法则包括了观察到的现象,其中构思并非是简化了的“观察现象”,而是与法则关系中的其他构思结合在一起来预测观察现象,法则关系方法能更加科学地揭示多变量间的关系。[45]

我们期望通过把元分析方法与法则关系结合起来,可以综合这两种方法的优点,实现优势互补。举例来说,假定研究人员先前已就研究课题相关的文献作了全面、认真地回顾,所阅读文献中的研究成果与结论就可以成为接下来所要进行研究的理论基础。[46]据此研究人员可以提出理论假设,对构思之间的可能关系作出符合逻辑的假设,构建构思之间以及构思内部各维度之间可能关系的法则关系。根据该法则关系编制出相应的测量工具,对研究对象进行施测,借助某些研究方法(如结构方程模型)以及软件(如SPSS、LISREL等)检验测量工具的法则有效性。若是发现构思之间以及构思内部各维度之间的关系显著,则可以证实所提出的理论;若是发现构思之间以及构思内部各维度之间的某些关系并非显著,此时,研究人员则需要仔细思考,查找原因,确认是法则关系部分(理论模型)的问题还是测量部分的问题,前者则需要修正模型与假设,后者则需要根据实际情况考虑是对测量工具做进一步调整、优化测验设计或是选择更合适的统计工具等,做到有的放矢。通过结合法则关系方法来寻找出重要以及准确的构思,并对构思之间以及构思内部各维度之间的关系有正确的认识。所得出的结论也许会为确定研究范围以及研究纳入/排除标准提供科学的指导,从而使得元分析方法所要搜索到的文献正是与研究主题密切相关的。法则关系方法与元分析方法结合在一起可能会使下面的目标得以实现,即:选择了理想中的文献(借助于法则关系方法),得出了科学的结论(借助于元分析方法)。就这点而言,其也与(1)中的建议相呼应。

但这只是一种构想,目前尚未进行相关的研究。在具体操作过程中,这两种方法结合在一起是否会违背两种方法各自的应用规则、研究设计上是否可行、对量表测得的数据进行统计检验时,若是发现两种方法得出的结论恰好相反,此时又该如何应对,等等。这些问题都有待于对此感兴趣的研究人员做进一步的探索。

(3)改善初始研究中的研究方法,重视Wanous等人所确定的元分析步骤中前面的一些步骤。Wanous等人(1989)确定了元分析步骤:第一,定义研究范围;第二,设定研究纳入/排除标准;第三,搜索符合标准的研究;第四,选择要被使用的研究;第五,提取数据;第六,为相关研究特征编码(对于调节变量分析);第七,若是有必要,决定是否把多重自变量和/或因变量分组;第八,计算效应值均值和方差;第九,决定是否寻找调节变量;第十,选择可能的调节变量;第十一,确定各个层面各个调节变量的效应值均值以及方差。他们当时认为除了第八、九、十一步骤之外,其余的都为判断步骤,即是需要研究人员做出判断。[47]然而Kisamore和Brannick(2008)经过研究,认为在选择固定效应模型或是随机效应模型时,还是需要对第八步骤做出判断。[48]在Wanous等人所确定的元分析步骤中,先前很多的元分析研究把重点放在后面的步骤上,并对后面的一些步骤做出了许多优化。然而,不管后面步骤的优化工作做得如何好,元分析也不一定就比初始研究(原始研究文献)中的数据、思想以及理论来得更好。[49]像前面所介绍的偏倚问题,其中一部分就是由初始研究中的研究方法以及某些客观因素所引起的。如果要使得组织研究中元分析具有最大的价值,未来的研究需要重新着重于元分析中前面的一些步骤。[50]现在已经有学者对此进行了探索,Wood的文章就是一个好的开始,其考虑到在实施元分析的前面阶段中,若是列入了重复研究成果可能会使元分析的结论发生偏倚、降低元分析方法的效度,故而有针对性地开发出了一个试探法(如图1所示)来对在文献搜索阶段查找到的研究成果进行检测,筛选出那些重复的研究成果。[51]国内一些学者也提出了元分析的步骤,比如,王重鸣教授(1990)把元分析的步骤概括为:(1)对以往研究文献的检索;(2)对研究的分类与编码;(3)研究结果的测定;(4)分析与评价。[52]夏凌翔(2005)在综合前人研究的基础上归纳出了元分析的基本操作过程:(1)提出问题,制定计划;(2)检索相关文献;(3)对文献进行编码,并根据纳入标准,选出符合要求的纳入文献;(4)纳入研究的质量评价;(5)正确进行数据提取;(6)资料的统计学处理;(7)结果的敏感性分析;(8)元分析结果的分析和讨论;(9)根据统计结果作出正确、全面的结论。[53]由于国内学者对元分析的实证研究较少,因此,对整个元分析的步骤深入研究以提升其效度也成为国内元分析研究的重要课题。

由以上内容可知,影响元分析研究准确与否的因素包括了初始研究中的数据、初始研究所使用的方法以及元分析的各个流程等。要想使系统化偏倚问题得以妥善解决、元分析方法的效度得到改善与提高,这三点建议应当引起研究人员的充分重视。

六、总 结

本文对元分析方法的最新研究成果进行了梳理,阐述了如何对重复研究成果进行正确地鉴别与合适地处理、选择合适的元分析模型、比较用来评估分类变量调节效应的各种元分析方法、妥善地解决系统化偏倚的问题,从而有力地提升了元分析方法的效度。需要注意的是,本文中所列出的元分析相关的最新研究成果,是基于组织研究的视角,有些结论是基于模拟数据或者特定的假设(如数据分布是正态分布)而得出的,在应用这些研究成果的同时需要充分考虑情境化因素。当然,方法总是在不断发展中的,结合本文所总结出的该方法的最新研究成果,相信元分析技术在不断改进、不断完善的同时也一定能够更好地促进各学科的发展。

【注释】

[1]冯明,重庆大学经济与工商管理学院。

[2]Glass,G.V.Primary,secondary,and meta-analysis of research[J].Education Research,1976,6:3-8.

[3]王重鸣:《心理学研究方法》,人民教育出版社1990年版。

[4]Schmidt,F.L.Meta-analysis:A constantly evolving research integration tool[J].OrganizationalResearch Methods,2008,11:96-113.

[5]徐秩元、耿文秀:《国外对罪犯心理矫治研究的元分析》,《心理学动态》1999年第7期。

[6]王重鸣:《心理学研究方法》,人民教育出版社1990年版。Schmidt,F.L.Meta-analysis:A constantly evolving research integration tool[J].OrganizationalResearch Methods,2008,11:96-113.夏凌翔:《元分析及其在社会科学研究中的应用》,《西北师大学报(社会科学版)》2005年第5期。Bobko,P.&Roth,P.L.Psychometric accuracy and(the continuing need for) quality thinking in meta-analysis[J].Organizational Research Methods,2008,11: 114-126.Dalton,D.R.&Dalton,C.M.Meta-analyses:Some very good steps toward a bit longer journey[J].Organizational Research Methods,2008,11:127-147.K isamore,J.L.&Brannick,M.T.An illustration of the consequences of meta-analysismodel choice[J].Organizational Research Methods,2008,11:35-53.Morris,S.B.Book Review:Hunter,J.E.&Schmidt,F.L.(2004).Methods of Meta-Analysis:Correcting Error and Bias in Research Findings(2nd ed.).Thousand Oaks,CA:Sage[J].Organizational Research Methods,2008,11:184-187.Wood,J.A.Methodology for dealingwith duplicate study effects in a meta-analysis[J].OrganizationalResearch Methods,2008,11:79-95.

[7]Bobko,P.&Roth,P.L.Psychometric accuracy and(the continuing need for)quality thinking in meta-analysis[J].Organizational Research Methods,2008,11:114-126.

[8]Wood,J.A.Methodology for dealing with duplicate study effects in a meta-analysis[J].Organizational Research Methods,2008,11:79-95.Stewart,W.H.,&Roth,P.L.Data quality affectsmeta-analytic conclusions:A response toM iner and Raju(2004)concerning entrepreneurial risk propensity[J].Journal of Applied Psychology,2004,89(1):14-21.

[9]Bobko,P.&Roth,P.L.(2003).Meta-analysis and validity generalizations as research tools:Issues of sample bias and degrees of misspecification[A].In K.R.Murphy(Ed.),Validity generalization:A critical review[C].Mahwah,NJ:Lawrence Erlbaum(pp.67-90).Strube,M.J.A generalmodel for estimating and correcting the effects of nonindependence in metaanalysis[J].Multiple Linear Regression Viewpoints,1987,16(2):40-47.

[10]Wood,J.A.Methodology for dealing with duplicate study effects in a meta-analysis[J].Organizational Research Methods,2008,11:79-95.

[11]Wood,J.A.Methodology for dealing with duplicate study effects in a meta-analysis[J].OrganizationalResearch Methods,2008,11:79-95.

[12]Wood,J.A.Methodology for dealing with duplicate study effects in a meta-analysis[J].OrganizationalResearch Methods,2008,11:79-95.

[13]Wood,J.A.Methodology for dealing with duplicate study effects in ametaanalysis[J].Organizational Research Methods,2008,11:79-95.

[14]Hunter,J.E.&Schmidt,F.L.(2004).Methods of meta-analysis: Correcting error and bias in research findings(2nd ed.)[M].Thousand Oaks,CA: Sage.

[15]Bobko,P.&Roth,P.L.Psychometric accuracy and(the continuing need for)quality thinking in meta-analysis[J].Organizational Research Methods,2008,11:114-126.

[16]Waldman,D.&Avolio,B.Race effects in performance evaluations: Controlling for ability,education,and experience[J].Journal of Applied Psychology,1991,76:897-901.

[17]Rotundo,M.&Sackett,P.E ffect of rater race on conclusions regarding differential prediction in cognitive ability tests[J].Journal of Applied Psychology,1999,84:815-822.

[18]Bobko,P.&Roth,P.L.Psychometric accuracy and(the continuing need for)quality thinking in meta-analysis[J].Organizational Research Methods,2008,11:114-126.

[19]Wood,J.A.Methodology for dealing with duplicate study effects in a meta-analysis[J].Organizational Research Methods,2008,11:79-95.

[20]Schmidt,F.L.Meta-analysis:A constantly evolving research integration tool[J].OrganizationalResearch Methods,2008,11:96-113.

[21]Wood,J.A.Methodology for dealing with duplicate study effects in a meta-analysis[J].OrganizationalResearch Methods,2008,11:79-95.

[22]夏凌翔:《元分析及其在社会科学研究中的应用》,《西北师大学报(社会科学版)》2005年第5期。

[23]Kisamore,J.L.&Brannick,M.T.An illustration of the consequences of meta-analysismodel choice[J].OrganizationalResearch Methods,2008,11:35-53.

[24]Lipsey,M.W.&W ilson,D.B.(2001).Practical meta-analysis[M].Thousand Oaks,CA:Sage.

[25]Kisamore,J.L.&Brannick,M.T.An illustration of the consequences of meta-analysismodel choice[J].OrganizationalResearch Methods,2008,11:35-53.

[26]Lipsey,M.W.&W ilson,D.B.(2001).Practicalmeta-analysis[M].Thousand Oaks,CA:Sage.Hedges,L.V.&Vevea,J.L.Fixed-and randomeffects models in meta-analysis[J].Psychological Methods,1998,3:486-504.Wang,M.C.&Bushman,B.J.(1999).Integrating results throughmeta-analytic review using SAS software[M].Cary,NC:SAS Institute.

[27]Kisamore,J.L.&Brannick,M.T.An illustration of the consequences of meta-analysismodel choice[J].Organizational Research Methods,2008,11:35-53.

[28]Kisamore,J.L.&Brannick,M.T.An illustration of the consequences of meta-analysismodel choice[J].OrganizationalResearch Methods,2008,11:35-53.

[29]Kisamore,J.L.&Brannick,M.T.An illustration of the consequences of meta-analysismodel choice[J].OrganizationalResearch Methods,2008,11:35-53.

[30]Kisamore,J.L.&Brannick,M.T.An illustration of the consequences of meta-analysismodel choice[J].Organizational Research Methods,2008,11:35-53.

[31]Kisamore,J.L.&Brannick,M.T.An illustration of the consequences of meta-analysismodel choice[J].OrganizationalResearch Methods,2008,11:35-53.

[32]Hedges,L.V.&Vevea,J.L.Fixed-and random-effectsmodels inmetaanalysis[J].Psychological Methods,1998,3:486-504.Hunter,J.E.&Schmidt,F.L.Fixed effects vs.random effectsmeta-analysismodels:Implications for cumulative research knowledge[J].International Journal of Selection and Assessment,2000,8:275-292.

[33]Kisamore,J.L.&Brannick,M.T.An illustration of the consequences of meta-analysismodel choice[J].OrganizationalResearch Methods,2008,11:35-53.

[34]Aguinis,H.(2007).Performance management[M].Upper Saddle River,NJ:Pearson Prentice Hall.Aguinis,H.(2004).Regression analysis for categoricalmoderators[M].New York:Guilford.Aguinis,H.Petersen,S.A.&Pierce,C.A.Appraisal of the homogeneity of error variance assumption and alternatives to multiple regression for estimating moderating effects of categorical variables[J].OrganizationalResearch Methods,1999,2:315-339.

[35]Aguinis,H.Sturman,M.C.&Pierce,C.A.Comparison ofThreeMeta-Analytic Procedures for Estimating Moderating Effects of Categorical Variables[J].OrganizationalResearch Methods,2008,11:9-34.

[36]Aguinis,H.Sturman,M.C.&Pierce,C.A.Comparison ofThreeMeta-Analytic Procedures for Estimating Moderating Effects of Categorical Variables[J].OrganizationalResearch Methods,2008,11:9-34.

[37]Hedges,L.V.&Olkin,I.(1985).Statistical methods for meta-analysis[M].Orlando,FL:Academic Press.

[38]Hunter,J.E.&Schmidt,F.L.(2004).Methods of meta-analysis: Correcting error and bias in research findings(2nd ed.)[M].Thousand Oaks,CA: Sage.Hunter,J.E.&Schmidt,F.L.(1990).Methods ofmeta-analysis:Correcting error and bias in research findings[M].Newbury Park,CA:Sage.

[39]Aguinis,H.&Pierce,C.A.Testing moderator variable hypotheses metaanalytically[J].Journal ofManagement,1998,24:577-592.

[40]Aguinis,H.Sturman,M.C.&Pierce,C.A.Comparison ofThreeMeta-Analytic Procedures for Estimating Moderating Effects of Categorical Variables[J].OrganizationalResearch Methods,2008,11:9-34.

[41]Bobko,P.&Roth,P.L.Psychometric accuracy and(the continuing need for)quality thinking in meta-analysis[J].Organizational Research Methods,2008,11:114-126.

[42]K raemer,H.Gardner,C.Brooks,J.&Yesavage,J.Advantages of excluding underpowered studies in meta-analysis:Inclusionist versus exclusionist viewpoints[J].PsychologicalMethods,1998,3:23-31.

[43]Bobko,P.&Roth,P.L.Psychometric accuracy and(the continuing need for)quality thinking inmeta-analysis[J].Organizational Research Methods,2008,11: 114-126.

[44]Bobko,P.&Roth,P.L.(2003).Meta-analysis and validity generalizations as research tools:Issues of sample bias and degrees of misspecification[A].In K.R.Murphy(Ed.),Validity generalization:A critical review[C].Mahwah,NJ:Lawrence Erlbaum(pp.67-90).Bobko,P.&Stone-Romero,E.(1998).Meta-analysis is another useful research tool but it is not a panacea[A].In J.Ferris(Ed.),Research in personnel and human resources management[C].Greenwich,CT:JAI(Vol.16,pp.359-397).

[45]Cronbach,L.J.&Meehl,P.E.Construct validity in psychological tests[J].Psychological Bulletin,1955,52:281-302.

[46]参见陈晓萍、徐淑英、樊景立主编:《组织与管理研究的实证方法》,北京大学出版社2008年版。

[47]Wanous,J.P.Sullivan,S.E.&Malinak,J.The role of judgment calls inmeta-analysis[J].Journal ofApplied Psychology,1989,74:259-264.

[48]Kisamore,J.L.&Brannick,M.T.An illustration of the consequences of meta-analysismodel choice[J].OrganizationalResearch Methods,2008,11:35-53.

[49]Bobko,P.&Roth,P.L.Psychometric accuracy and(the continuing need for)quality thinking in meta-analysis[J].Organizational Research Methods,2008,11:114-126.

[50]Bobko,P.&Roth,P.L.Psychometric accuracy and(the continuing need for)quality thinking in meta-analysis[J].Organizational Research Methods,2008,11:114-126.

[51]Wood,J.A.Methodology for dealing with duplicate study effects in a meta-analysis[J].OrganizationalResearch Methods,2008,11:79-95.

[52]王重鸣:《心理学研究方法》,人民教育出版社1990年版。

[53]夏凌翔:《元分析及其在社会科学研究中的应用》,《西北师大学报(社会科学版)》2005年第5期。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。